Управление поисковыми роботами – самый важный из первых шагов. Осуществляется это через robots.txt – системный файл, отвечающий за обход. В статье разобрались, как оптимально его написать для WordPress.

Зачем создавать robots.txt для блога на WordPress?

В сообществе вебмастеров ошибочно считают, что блог под управлением CMS не нуждается в точечной настройке robots.txt, однако на примере WordPress, имеющего как множество собственных системных страниц, которые не должны попасть в индекс, так и генерируемых плагинами, понятно, что без ручного управления – сайт не продвинется.

К мусорным категориям можно причислить:

- Пагинацию – навигационные документы, содержащие неуникальный (цитаты из основного материала) контент и внутренние ссылки (с индексацией записей). Такой мусор будет снижать общую ценность всего ресурса.

- Дубли – копии уже существующих материалов. Глобальная уникальность падает.

- Архивы – для обычного информационника на ВордПресс вредные элементы. По последствиям применения схожи с пагинационными.

Как итог: падение в результатах поиска продвигаемых статей. Дальше оптимизировать будет тяжело и безрезультатно.

Избежать этого можно настроив robots.txt.

Расположение в WordPress

При вопросе где находится robots.txt в системе, попробуйте добавить его через слеш к адресу вашего сайта:

https://site.ru/robots.txtЕсли он лежит не там, то создайте его в материнской директории.

Почему я не могу найти robots.txt?

Работая с CMS есть шанс, что он виртуальный. То есть получить к нему доступ непосредственно из папки невозможно, как и вручную отредактировать, потому что изменить его можно только через админку. При этом не путайте c meta name robots. Это два разных компонента: txt (текстовый) файл и мета-тег.

Глоссарий применяемых команд

Я выделяю минимум, который надо знать при использовании роботса:

- User-agent – позволяет создавать разные сценарии для нескольких роботов, зачастую разных поисковиков;

- Allow – принудительное разрешение страницы к попаданию в поиск.

- Disallow – ручной запрет на индексирование;

- Sitemap – указание XML или HTML карты сайта, в которой содержатся урлы всех страниц;

- Crawl-delay – команда ограничения обходимых документов, используется при повышенной нагрузке на хостинг (не работает в Яндексе);

- Host – добавление используемого домена, полезно при склейке (воспринимает только Google, Bing и Yahoo);

- “#” – знак комментирования, все, что находится за ним не воспринимается ботами;

- “*” – любое количество знаков после символа.

Рабочий вариант robots.txt для WordPress

Используйте этот фрагмент, он включает в себя все важные элементы. Помимо этого, он лучший по оптимизации объема кода:

Как редактировать robots.txt?

Если документ уже создан, необходимо настроить его для сайта, учитывая особенности и недочеты. Сделать как через WordPress плагины, так и вручную, через панель управления сервером или FTP.

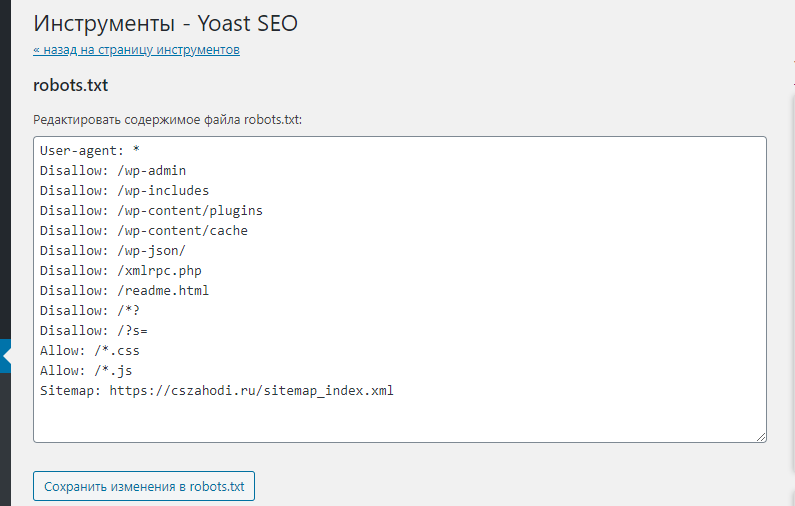

Через Yoast SEO

Маст-хэв расширение для базового SEO в WordPress. В рамках базового функционала также позволяет вручную через изменять robots.txt.

Перейдите в Инструменты > Редактор файлов, далее вставьте нужные правки:

Теперь сохраните изменения и перейдите по оригинальному урлу, предварительно очистив кеш, нажав Ctrl + F5 или кликнув в кеширующем дополнении и проверьте внесенные изменения.

Аналогичен модуль All In One Pack. Отдельно не стану его разбирать.

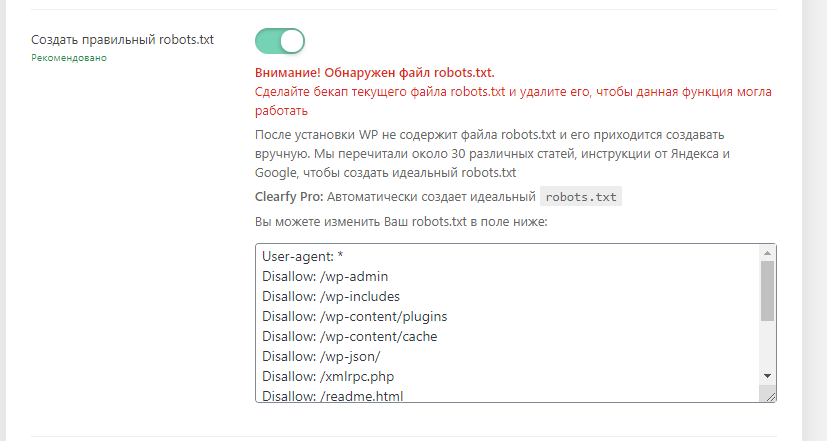

Используя Clearfy PRO

Второе, самое лучшее решение для WordPress, позволяющее разом добавлять множество правил. Помимо автоматического идеального заполнения robots.txt оптимизирует сайт по 57 параметрам.

Чтобы найти нужный чекбокс, откройте раздел SEO в конфигурации модуля в админ-панеле WP. Дальше WordPress плагин выполнит работу самостоятельно.

Скидка 15% по промокоду wpboost

Другие промокоды от этой компании ищите здесь.

Правильный шаблон для WooCommerce

Если вы используете эту утилиту (скачать) для интернет-магазина, то кроме стандартного сеттинга robots.txt для WordPress добавьте следующие пункты:

Они не только исключат из поиска дубли, появляющиеся при наполнении онлайн корзины, ее просмотре, биллинге, но и сберегут логины пользователей, которые по ошибки могут индексировать ПС (иначе через Google Dorking можно будет их спарсить).

Составьте через уже разобранные способы. Функция PHP будет только перегружать ресурс.